- Startseite

- Lexikon

Lexikon

Hier findest du Erklärungen von vielen Wörtern und Begriffen zum Thema Krieg und Frieden

Kolonie

Kolonie bedeutet, wenn die Regierung eines Landes Gebiete außerhalb ihres eigenen Landes erobert und beherrschert.

Bereits Anfang des 15. Jahrhunderts gab es die ersten Kolonien. Damals eroberten große europäische Seefahrernationen, wie z.B. Großbritannien, Spanien , Portugal, Belgien und Frankreich Gebiete in Amerika, Afrika und Asien. Gegen Ende des 19. Jahrhunderts wurde auch Deutschland eine Kolonialmacht mit seinen Kolonien in Afrika.

Nach der Eroberung zog ein Teil der europäischen Bevölkerung in diese neu errichteten Kolonien. Die einheimische Bevölkerung wurde vertrieben, versklavt oder musste harte menschenunwürdige Arbeiten verrichten. Oftmals wurden ihnen sogar alle Rechte genommen.

Besonders großes Interesse hatten die europäischen Erobererländer an Salz, Kaffe, Tee, Bananen und andere unbekannte Früchte, Gewürze, Tabak, Gold und Diamanten. Diese konnten sie für wenig oder gar kein Geld in den Kolonien erwerben und teuer im eigenen Land verkaufen.

Erst nach dem Zweiten Weltkrieg erlangten die meisten Koloniestaaten ihre Unabhängigkeit.

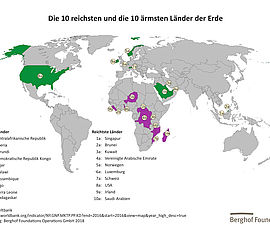

Leider hat die Zeit der Kolonisation bis heute negative Auswirkungen für die Menschen in Afrika, Asien und Südamerika. Viele Kolonialgebiete sind arm, von Krieg betroffen und immer noch wirtschaftlich abhängig von europäischen Ländern.